È appena cominciata l’opera creativa di esplorare le opportunità di utilizzo dell’intelligenza artificiale per i cittadini e le imprese. I rischi sono stati intravisti. Si apre un’alternativa pessima: da una parte, la tentazione di partire con le opportunità e dimenticare i rischi; dall’altra, la tentazione di bloccare tutto per timore dei rischi e impedire di cogliere le opportunità. Molte imprese temono che in Europa la normativa sull’intelligenza artificiale accoppiata a quella della privacy si configuri come un freno decisivo. E poiché in America si fanno meno scrupoli, alcune imprese pensano di andarsene. La soluzione è smettere di tranciare giudizi affrettati sulle leggi e sulla tecnologia, togliere di mezzo i pregiudizi, smettere di pensare alle leggi come freni e alle tecnologie come rischi: considerare l’insieme. Non sarà facile. Dunque l’aggiustamento normativo non sarà breve. Ma deve essere fatto.

Vediamo che cosa ha insegnato l’intervento del Garante su OpenAI. E raccogliamo alcuni fatti che inducono a non sottovalutare la vicenda.

Si può fare una scommessa. La vicenda aperta dal Garante per la protezione dei dati personali italiano si concluderà a un certo punto, ma sarà soltanto l’inizio di una questione complessa e lunga. Siamo in attesa di conoscere la risposta di OpenAI al Garante che in effetti potrebbe chiudere la partita italiana immediata. Ma molto probabilmente non risolverà tutto. Perché da questa vicenda abbiamo imparato che:

– non è vero che l’intervento del Garante sia stato immotivato e abbia fatto fare brutta figura all’Italia; Canada, Germania, Bruxelles stanno considerando il problema sollevato dal Garante italiano; la stampa internazionale non ha assolutamente sottovalutato l’intervento del Garante italiano

– è vero che l’intervento del Garante ha generato giudizi molto negativi sulla normativa per la privacy europea soprattutto tra le aziende digitali europee che ammirano la libertà d’azione di cui godono le loro omologhe americane

– è vero che l’intelligenza artificiale generativa è in mano a un oligopolio che sta facendo esattamente quello che vuole per ora; l’intervento del Garante italiano potrebbe condurre OpenAI a prendere misure un po’ più attente ai diritti dei cittadini (siamo in attesa di notizie)

– è vero che i rischi sono elevati, le misure da prendere sono complesse, i cittadini sono la parte debole del fenomeno e le imprese devono avere qualche certezza sul quadro normativo per poter investire.

In questo post riporto i motivi che inducono a pensare che tutta questa vicenda sia tutt’altro che banale. In sintesi questi sono i problemi emersi, in ordine di priorità (cioè in ordine di precisione del problema e di definibilità delle misure da prendere):

1. Le informazioni che gli utenti immettono nelle chat o comunque come prompt per le intelligenze artificiali generative sono dati potenzialmente sensibili che le piattaforme possono usare per adesso a loro piacimento con potenziali conseguenze molto negative per gli utenti

2. La protezione dei bambini è totalmente assente dalle piattaforme, si può risolvere banalmente con avvertenze più chiare ma probabilmente questo non basterà, sicchè le piattaforme dovranno prendersi impegni più netti, magari aprendosi a ricercatori indipendenti

3. Le informazioni sulle persone usate dalle piattaforme per addestrare le loro intelligenze artificiali sono evidentemente presenti in rete per altri motivi, anche quando sono vecchie, false o diffamanti; le misure conseguenti sono piuttosto complesse e non troppo dissimili da quelle che si dovrebbero usare per i motori di ricerca, probabilmente, che già si occupano di “diritto all’oblio” e altro; c’è chi suggerisce di pretendere che le piattaforme chiedano ai cittadini di opt out oppure addirittura opt in.

Come si vede la questione sarà lunga. Riguarderà un’eventuale riforma del GDPR, una nuova accentuazione delle misure anti-trust, una forte policy per il lancio e il sostegno di alternative all’olligopolio delle intelligenze artificiali, promuovendo architettura distribuita, apertura dei dati alla ricerca scientifica, educazione dei cittadini.

La vicenda non è stata una brutta figura italiana, ma ha scoperchiato una realtà difficilissima da affrontare. Ecco alcuni casi che lo dimostrano.

MyAI di Snapchat avverte: non condividete segreti con la chat. “As with all AI-powered chatbots, My AI is prone to hallucination and can be tricked into saying just about anything. Please be aware of its many deficiencies and sorry in advance! All conversations with My AI will be stored and may be reviewed to improve the product experience. Please do not share any secrets with My AI and do not rely on it for advice.” (Arstechnica)

Dipendenti di Samsung condividono segreti industriali su ChatGPT. “Oops: Samsung Employees Leaked Confidential Data to ChatGPT Employees submitted source code and internal meetings to ChatGPT just weeks after the company lifted a ban on using the chatbot”. (Gizmodo)

Gli esperti: non dire a un chatbot niente che tu voglia tenere privato. “As the tech sector races to develop and deploy a crop of powerful new AI chatbots, their widespread adoption has ignited a new set of data privacy concerns among some companies, regulators and industry watchers. Some companies, including JPMorgan Chase (JPM), have clamped down on employees’ use of ChatGPT, the viral AI chatbot that first kicked off Big Tech’s AI arms race, due to compliance concerns related to employees’ use of third-party software. It only added to mounting privacy worries when OpenAI, the company behind ChatGPT, disclosed it had to take the tool offline temporarily on March 20 to fix a bug that allowed some users to see the subject lines from other users’ chat history. The same bug, now fixed, also made it possible “for some users to see another active user’s first and last name, email address, payment address, the last four digits (only) of a credit card number, and credit card expiration date,” OpenAI said in a blog post. And just last week, regulators in Italy issued a temporary ban on ChatGPT in the country, citing privacy concerns after OpenAI disclosed the breach.” (CNN)

Uno scandalo inventato da un’intelligenza artificiale inventata ha ripercussioni reali. “ChatGPT invented a sexual harassment scandal and named a real law prof as the accused. The AI chatbot can misrepresent key facts with great flourish, even citing a fake Washington Post article as evidence. “One night last week, the law professor Jonathan Turley got a troubling email. As part of a research study, a fellow lawyer in California had asked the AI chatbot ChatGPT to generate a list of legal scholars who had sexually harassed someone. Turley’s name was on the list. The chatbot, created by OpenAI, said Turley had made sexually suggestive comments and attempted to touch a student while on a class trip to Alaska, citing a March 2018 article in The Washington Post as the source of the information. The problem: No such article existed. There had never been a class trip to Alaska. And Turley said he’d never been accused of harassing a student. A regular commentator in the media, Turley had sometimes asked for corrections in news stories. But this time, there was no journalist or editor to call — and no way to correct the record. “It was quite chilling,” he said in an interview with The Post. “An allegation of this kind is incredibly harmful.” Turley’s experience is a case study in the pitfalls of the latest wave of language bots, which have captured mainstream attention with their ability to write computer code, craft poems and hold eerily humanlike conversations. But this creativity can also be an engine for erroneous claims; the models can misrepresent key facts with great flourish, even fabricating primary sources to back up their claims.” (Washington Post)

Tutto questo non toglie certo di mezzo le perplessità sul modo in cui la vicenda è emersa in Italia. Il pensiero di Carlo Blengino è sempre da riguardare. Intanto, Luciano Floridi: “Bloccare Chat Gpt è una misura draconiana. Impariamo a usarlo e facciamo le leggi”

Intanto si attende lo sblocco come riporta il Sole 24 Ore.

Ma le cose si allargheranno:

Per esempio al trattamento del copyright da parte delle intelligenze artificiali. “Stable Diffusion copyright lawsuits could be a legal earthquake for AI. Experts say generative AI is in uncharted legal waters”. (Arstechnica)

Le imprese europee dovrebbero cercare di cogliere l’opportunità di essere in un posto che pensa le conseguenze dell’innovazione. Non dovrebbero considerarsi penalizzate da una legislazione diversa da quella americana. Anche gli americani cominciano a rendersene conto. Ma al centro di tutto c’è il fatto che l’Europa deve trovare il modo di equilibrare la sua giusta attenzione ai diritti e una policy che incentivi le imprese europee a innovare nella direzione che faccia il bene di tutti. L’Europa sta innovando nella normativa. Deve riuscire a innovare anche nella policy complessiva. Altrimenti rischia di essere compresa soltanto a metà.

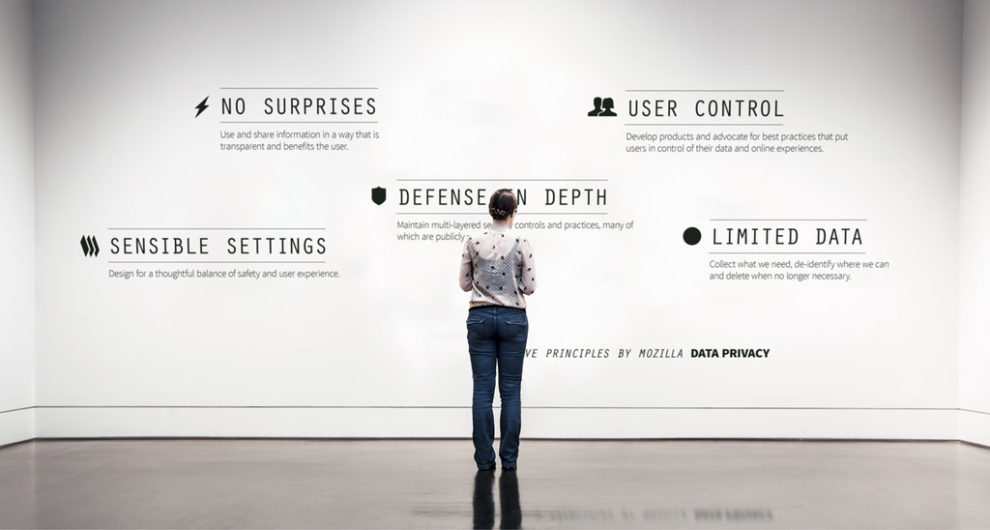

Foto: “Five Data Privacy Principles from Mozilla (Put on a museum wall) 2014” by vintagedept is licensed under CC BY 2.0.

Commenta