Questo è il quarto di una serie di post sul futuro. Un’esplorazione che riguarda quattro generi di questioni: perché pensare il futuro? come leggere il futuro nel presente? che cosa ci impedisce di lavorare sul futuro in modo libero da preconcetti? che cosa possiamo fare per favorire un futuro preferibile? Genere 4 – Qualche grande nuova narrazione dotata di senso L’Onu organizza in questi giorni il Summit of the future 2024. Tra gli output attesi c’è un “Patto per il futuro”, un insieme di proposte per la governance del digitale e una Dichiarazione di impegni per le...

visioni

Parliamo di futuri/3 – Non si difende il futuro per ottimismo

Questo è il terzo di una serie di post sul futuro. Un’esplorazione che riguarda quattro generi di questioni: perché pensare il futuro? come leggere il futuro nel presente? che cosa ci impedisce di lavorare sul futuro in modo libero da preconcetti? che cosa possiamo fare per favorire un futuro preferibile? Genere 3 – Liberare il futuro dai preconcetti Il futuro non è scritto. Anche perché il futuro non esiste, non è mai esistito. Ci sono però i nostri pensieri e le nostre azioni, con le loro conseguenze. Un classico modo per leggere le conseguenze è quello di credere a una narrativa. Che...

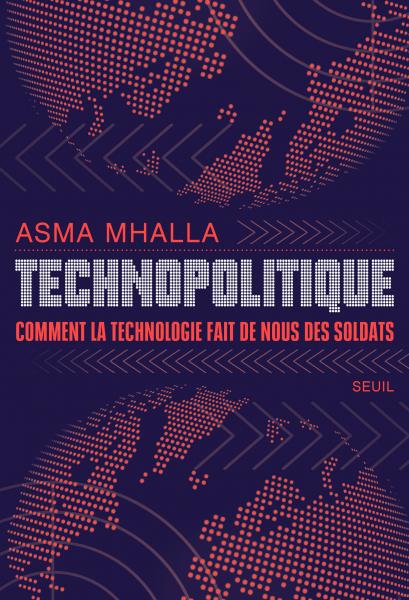

Parliamo di futuri/2 – Technopolitique. Asma Mhalla. BigTech e BigState. Il futuro del potere

Questo è il secondo di una serie di post sul futuro. Un’esplorazione che riguarda quattro generi di questioni: perché pensare il futuro? come leggere il futuro nel presente? che cosa ci impedisce di lavorare sul futuro in modo libero da preconcetti? che cosa possiamo fare per favorire un futuro preferibile? Genere 2 – Come leggere il futuro nel presente? Asma Mhalla è una straordinaria ricercatrice al Laboratoire d’Antropologie Politique de l’École des Hautes Études en Sciences Sociales. Leggere il suo libro, “Technopolitique. Comment la technologie fait de nous des...

Utopie Realiste alla Biennale Tecnologia 2024

È cominciata ieri notte la Biennale Tecnologia 2024 con una performance di Club Silencio. Migliaia di ragazzi sono arrivati al Politecnico di Torino creando un’atmosfera vivacemente pacata all’insegna della challenge per eccellenza: corridoio blu o corridoio rosso? Utopia e paradiso? Realismo e inferno? L’edizione 2024 della rassegna dedicata al rapporto tra tecnologia e società si ispira a queste due parole: Utopie Realiste. Oscar Wilde non scherzava sempre, ma mai rinunciava all’anticonformismo: «Il progresso è la realizzazione di Utopie». E ci vuole un pizzico di...

Dalla singolarità alla pluralità

L’idea della singolarità schiaccia il futuro in un solo spazio stretto definito da una sola interpretazione della tecnica. Quell’idea parla della crescita esponenziale delle capacità della tecnologia che si trasformerebbe in una forma di potere più grande di qualsiasi elaborazione e aggregazione umana. Ma se invece le possibilità fossero sempre più numerose di quelle previste dai portatori di acqua per i potenti della tecnologia e della finanza, la parola giusta sarebbe pluralità. La pluralità non nega l’avanzamento straordinario della tecnologia ma semplicemente lo vede come motore di una...

Libro. David J. Chalmers, Più realtà. I mondi virtuali e i problemi della filosofia

Questa non è una recensione del magnifico libro di David J. Chalmers, “Più realtà. I mondi virtuali e i problemi della filosofia”, Raffaello Cortina Editore 2023 (v.o. 2022). Questi sono appunti su quello che il libro evoca: la possibilità di porre domande filosofiche sulla tecnologia e di usare la tecnologia per rispondere a domande filosofiche. Per chiarire di che cosa parla quando si riferisce alla tecnologia, vale la pena di ricordare che Chalmers inizia raccontando dei suoi primi rapporti con il computer e sviluppa il concetto spiegando le sue storie con i videogiochi e le...

Scritti sull’acqua

La questione dell’acqua è da sempre decisiva per la forma che assumono le civiltà degli umani. E con il cambiamento climatico diventerà uno dei problemi più importanti per l’adattamento degli umani alle condizioni ecologiche che hanno generato con il consumo di combustibili fossili e il modello di sviluppo industriale degli ultimi due secoli. Occorre aumentare l’attenzione e l’informazione in materia. Ci sono iniziative importantissime che si stanno avviando in questi mesi. E cercheremo di darne conto. Intanto comincio con questi appunti. Appunti strategici sull’acqua...

Rai Radio 3, Università Roma 3. Automatica-mente al Teatro Palladium

Ieri sono stato sul palco del bellissimo Teatro Palladium di Roma, alla Garbatella, a raccontare il lavoro che stiamo facendo per scrivere un podcast per Rai Radio 3 sull’intelligenza artificiale. Il pubblico è stato fantastico. E poiché qualcuno lo ha chiesto, metto qui sotto un po’ di appunti. Magari mi potete correggere o segnalare integrazioni utili. INTELLIGENZA Qui si parla di intelligenza. La più grande caratteristica degli umani. Secondo alcuni vince di poco sulla loro stupidità. Secondo altri invece perde. La civiltà umana è una lunga espressione di intelligenza… o...

Un contributo per la scuola di giornalismo di Toronto: Il metodo è il messaggio

Ieri ho fatto una conferenza alla scuola di giornalismo della Toronto Metropolitan University. Un’esperienza che mi ha riempito di orgoglio per la qualità delle persone che erano presenti. E persino per l’accoglienza che hanno riservato alle mie proposte. For English speakers I add here the notes I took to prepare the speech. Notes will be revised for a better quality publication: Public talk at the Toronto Metropolitan University’s School of Journalism, March 15th 2023. Gli editori dei giornali hanno i loro problemi, grandi. E di conseguenza li hanno i giornalisti che lavorano...

The big media decoupling. Could be good news

Facebook is abandoning its newspaper collaboration project, it seems: Columbia Journalism Review has an article about it. Facebook stops investing in the project that began in 2019 with great fanfare. The reason: only 3 percent of posts circulating on the platform have a link to a newspaper article. It may be because people on Facebook are into other things and don’t want to know about newspapers. Or it may be because people have become accustomed to finding links to newspapers on Twitter. Or it may be because newspapers are increasingly visible only to subscribers. The fact is that...

Commenti