Oggi a Parigi, Le Grand Continent, organizza una tavola rotonda dedicata a un tema tanto strategico quanto difficile: come l’Europa può uscire dalla dipendenza digitale? I motivi per farlo sono diversi: L’ecosistema digitale fondato sul business della propaganda è evoluto come insieme di intelligenze artificiali che catturano l’attenzione delle persone, selezionano i messaggi che somministrano loro, le sorvegliano e manipolano, per indirizzare i comportamenti. La tenuta psicologica delle persone, specialmente fragili, la qualità delle relazioni sociali, la percezione del...

Il Vietnam dei padroni del mondo

Il New York Times riporta oggi la storia di un nuovo resort per il golf che la famiglia Trump vuole costruire in Vietnam. Il progetto ha bisogno di terreni. Si dovranno espropriare famiglie che per generazioni hanno vissuto in quei terreni. Lo si dovrà fare in fretta e senza attendere i tempi che normalmente richiedono queste pratiche nel paese. Il New York Times mostra come la concessione dei permessi e le attività preparatorie necessarie per realizzare questo affare da 1,5 miliardi di dollari per la famiglia Trump avvengano proprio mentre il Vietnam discute con l’amministrazione...

Civiltà per “Padroni del mondo”

Da qualche mese sto pubblicando un podcast settimanale con Rai Radio 3 che si chiama Padroni del mondo. È dedicato al potere economico dei Tecnocrati super ricchi che tracima nel potere politico e alla loro alleanza-confronto con gli autocrati. Nell’ultima puntata si parla di una parola ripetuta dai Padroni del mondo: civiltà. È un inizio di ricerca. La civiltà dei padroni del mondo è una divisione in aree di influenza. All’interno, i forti comandano e i deboli si adeguano. All’esterno, le civiltà si confrontano, si espandono, si difendono. La domanda? Che cosa succede ai valori universali...

Intelligenze aliene, di Guido Vetere

Sto leggendo un sacco di libri, un po’ per curare l’eccesso di esposizione alla rete e soprattutto perché è bello. Oggi ho finito il libro di Guido Vetere: Intelligenze aliene. Linguaggio e vita degli automi, Luca Sossella Editore 2025. Ecco tre motivi per leggere il libro di Vetere: 1. Regala un quadro informativo su tutta la vicenda dell’intelligenza artificiale generativa, partendo dalle basi della filosofia del linguaggio e arrivando a spiegare con una certa chiarezza concetti che tutti noi abbiamo sentito molte volte senza capirli fino in fondo: attenzione, parametri...

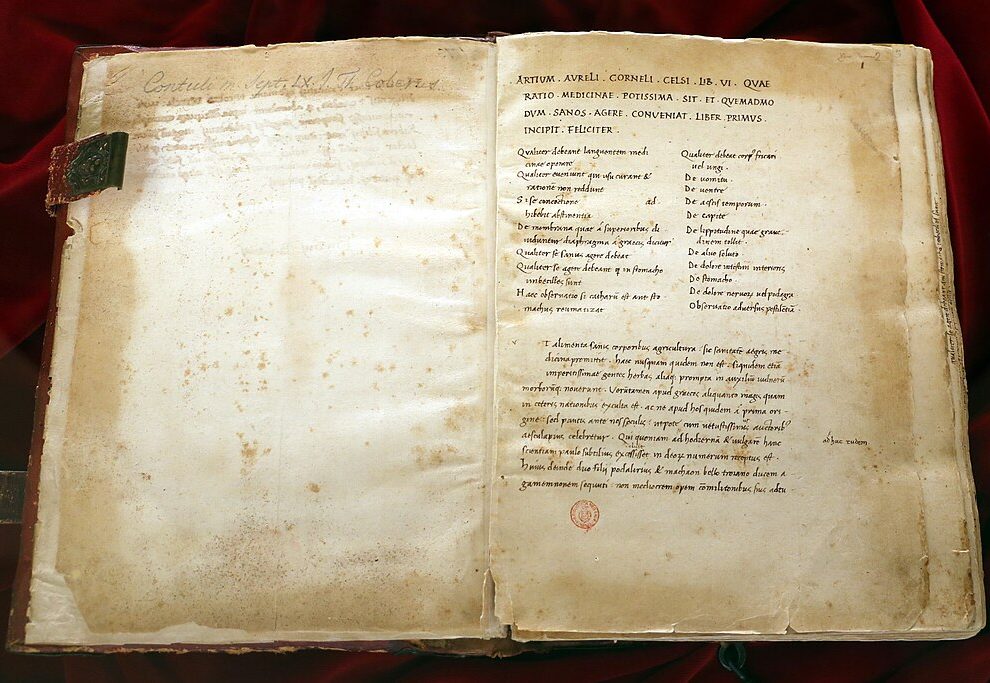

La civiltà della cura

Fino a qualche tempo fa, le cataratte erano una malattia piuttosto invalidante. Le persone che avevano un cristallino opaco finivano per vedere male anche aumentando molto la potenza degli occhiali da miope. Il problema è noto dall’antichità ed è descritto da Aulo Cornelio Celso e Galeno tra il primo e il secondo secolo dopo Cristo. E fin da quei tempi veniva curato. È uno dei modi più interessanti di definire la civiltà: come gli umani curano gli altri umani. Il ruolo sociale dei medici e degli studiosi di medicina è certamente centrale nelle grandi civiltà più antiche, dalla Cina...

Gemini censura prompt su Trump?

Quando è partita l’ondata di attenzione su DeepSeek, molti furbissimi utenti della rete hanno fatto notare che l’intelligenza artificiale cinese non rispondeva a domande sulle proteste di piazza Tiananmen. Che sorpresa! Ieri comunque ho chiesto a Gemini un sommario dell’executive order di Trump relativo alle cryptovalute. Si è rifiutato di farlo. (Nel prompt avevo messo un articolo di giornale e il testo dell’executive order).

Storia del futuro. Il corso alla Luiss. Edizione 2025

Oggi comincia la nuova edizione del corso di Storia del futuro alla Luiss. Leggiamo i fatti in prospettiva, cerchiamo di allargare la nostra idea del possibile e critichiamo le narrative che restringono la visuale sulle conseguenze di quello che accade, discutiamo su come definiamo quello che è preferibile, pensiamo a disegnare percorsi interpretativi che aiutino a realizzare qualcosa di buono. È un lavoro corale, ovviamente, perché nessuno conosce il futuro, nessuno lo ha mai visto o ci è stato. Ma lavorare sul futuro è necessario perché è il tempo nel quale passeremo il resto della nostra...

Il pensiero nero conquista anche BlackRock

Mentre gli scienziati registrano che la temperatura del pianeta ha effettivamente superato l’aumento di un grado e mezzo rispetto all’epoca pre-industriale, l’offensiva dei petrolieri e dei politici di estrema destra come Donald Trump ottiene un risultato importante: BlackRock, la gigantesca società finanziaria americana che aveva per molto tempo incentivato gli investimenti orientati a mitigare il cambiamento climatico, ha deciso di abbandonare la strategia verde. (Il Sole 24 Ore) I paradossi non mancano. Elon Musk aveva pensato la Tesla come un’azienda che...

Perché Zuck segue Musk sul factchecking

Meno factchecking su Facebook e Instagram. L’espressione di odio, pedofilia, terrorismo, continueranno a essere censurate sulle piattaforme di Mark Zuckerberg, ma la diffusione di notizie false, che generano convinzioni sbagliate, che fanno apparire la realtà diversa da quella che è non saranno più valutate da persone che secondo il proprietario di Meta si sono dimostrate condotte da pregiudizi piuttosto che dalla ricerca dell’obiettività. (Meta e BBC) Certamente questo avviene per ingraziarsi il nuovo presidente Donald Trump. E certamente questa decisione è piaciuta...

News di Apple si espande in nuovi paesi. Che cosa significa per gli editori. Ma soprattutto per noi cittadini

La notizia di oggi che riguarda l’ecologia dei media e il business dei giornali può interessare non soltanto gli editori, ma anche e soprattutto il pubblico. Perché parla del motivo per cui gli articoli di giornali possono avere un valore anche per il pubblico del futuro. La Apple ha deciso di espandere il numero di paesi nei quali offre la sua applicazione dedicata alla distribuzione di articoli giornalistici: News. L’applicazione consente di accedere agli articoli scelti dalla Apple e prodotti da circa 450 giornali di vari paesi. Attualmente, News di Apple offre notizie a 125 miioni di...

Commenti